Schöne neue digitale Arbeitswelt: Sie entwickelt sich in vielen Unternehmen in rasantem Tempo. Der aktuell wichtigste Treiber: künstliche Intelligenz, kurz KI. „Sie hat mittlerweile in vielen Arbeitsbereichen Einzug gehalten – und das oft fast unmerklich.“ So sagt es Thomas Prinz, Experte für Arbeitsrecht bei der Bundesvereinigung der Deutschen Arbeitgeberverbände (BDA).

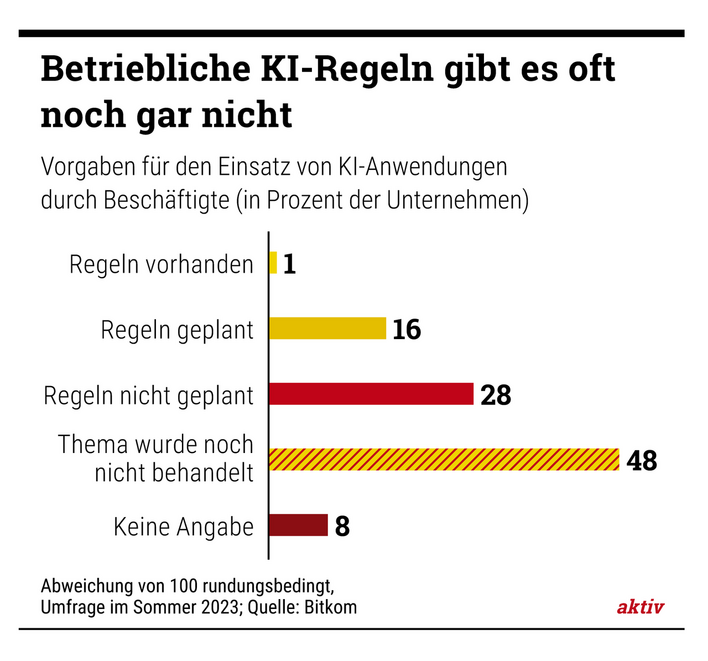

Eine aktuelle Befragung des Digitalverbands Bitkom belegt: Zwei Drittel der Bundesbürger sind davon überzeugt, dass KI-Anwendungen wie ChatGPT ihr persönliches (Arbeits-)Leben grundlegend verändern werden.

Verlockende KI-Tools gibt es für viele Zwecke

Solche KI-Tools können mit schriftlichen Arbeitsanweisungen, sogenannten Prompts, Texte und Bilder erstellen. Sie können auch große Datenmengen auswerten oder als Assistenzsysteme etwa bei der Maschinensteuerung eingesetzt werden.

Lesen Sie auf aktiv-online.de auch, wo solche schlauen Bots noch eingesetzt werden.

Damit stellen sich sofort Fragen: Wie sollten Mitarbeiter mit den teils sensiblen Daten umgehen, die die KI benötigt, um Ergebnisse zu liefern? Und wie dürfen die generierten Informationen genutzt werden? Kurz gesagt: Was darf man da eigentlich?

Das Arbeitsrecht liefert wichtige Leitplanken für den Umgang mit KI

Thomas Prinz, stellvertretender Abteilungsleiter Arbeitsrecht, BDA

Doch Prinz beruhigt: „Für den täglichen Umgang mit KI-Anwendungen liefert auch das existierende Arbeitsrecht wichtige Leitplanken.“ Der Experte zählt drei auf: Arbeitsleistung – Urheberrecht – und vor allem: Datenschutz.

Für die Fehler von ChatGPT steht man letztlich selbst ein

Wer beispielsweise von seiner Chefin die Aufgabe erhält, eine Ausarbeitung zu einem bestimmten Thema zu erstellen, darf durchaus ChatGPT für eine erste Recherche nutzen. Gibt man dann aber die Arbeit des Chatbots einfach als die eigene aus – „dann verstößt man gegen den Grundsatz der höchstpersönlichen Arbeitsleistung“, warnt Prinz. Und damit verletzt man Pflichten aus dem Arbeitsvertrag.

Außerdem stellen sich oft Fragen des Urheberrechts, gegen das verstoßen werden könnte. „Auch aus diesem Grund sollten solche Ausarbeitungen immer mit dem Vermerk ‚KI-generiert‘ versehen werden“, empfiehlt Prinz. Denn gerade beim Thema „Urheberrecht versus KI“ gebe es noch viele ungeklärte Fragen.

Und wenn sich in eine KI-Recherche unmerklich Fehler eingeschlichen haben? „Dann muss der Arbeitnehmer für die Fehler, die etwa ChatGPT gemacht hat, wie für seine haften“, erklärt Professor Peter Wedde von der Frankfurt University of Applied Sciences, Experte für den Einsatz von KI im Betrieb. Und so etwas kann schnell passieren: Laufend kommt es vor, dass etwa ChatGPT Fakten oder Quellen einfach erfindet. Zudem sind KI-Ergebnisse nicht reproduzierbar. Das heißt: Es ist durchaus möglich, auf ein und dieselbe Frage unterschiedliche Antworten zu bekommen. Jedwedes KI-Ergebnis sollte man also gewissenhaft nachprüfen.

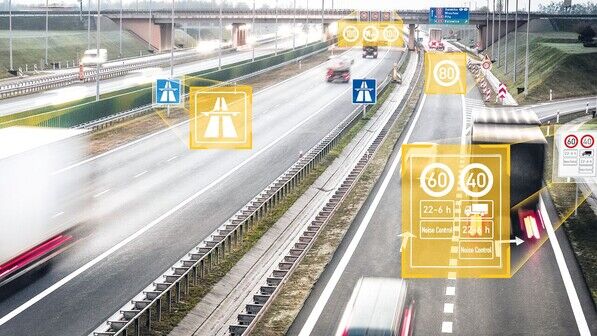

Heikel wird es auch, wenn es um personenbezogene oder geschäftliche Daten geht, die oft in den Bereich der Betriebsgeheimnisse fallen: Kundendaten etwa, Angebotsunterlagen oder Berichte aus der Entwicklungsabteilung. Sie sollten nur in gesicherten Unternehmensnetzwerken verwendet werden!

„Mitarbeiter, die mit einem externen KI-Tool wie ChatGPT arbeiten, müssen sich im Klaren darüber sein, dass die eingegebenen Daten auch dazu benutzt werden können, diese KI zu trainieren“, sagt Wedde. Was dann mit diesen Daten genau passiert, ist unklar. Deshalb sollte man unbedingt vermeiden, solche betrieblichen Daten in ein externes KI-Tool einzugeben!

Faustregel: Erst fragen – dann prompten

BDA-Experte Prinz sagt dazu: „Hat ein Arbeitnehmer sogar vorsätzlich sensible Daten etwa in ChatGPT eingegeben und dem Unternehmen ist dadurch ein Schaden entstanden, kann der Arbeitnehmer dafür haftbar gemacht werden.“ Es könne Schadenersatzforderungen geben und womöglich sogar eine verhaltensbedingte Kündigung. Auch dann, wenn ein Mitarbeiter im Auftrag des Chefs mit KI gearbeitet hat, gilt: „KI-generierte Ergebnisse müssen immer sorgfältig auf ihre Richtigkeit kontrolliert werden“, so Prinz.

Was beide Experten empfehlen: Beschäftigte sollten sich stets rückversichern und nachfragen, ob und womit sie eine KI füttern dürfen. Und was man sich immer klarmachen muss: Eine Anweisung des Arbeitgebers macht eine KI noch nicht zu einem verlässlichen Arbeitsmittel!

Der KI-Bot ChatGPT

- ChatGPT ist ein KI-unterstütztes, interaktives Sprachmodell. Das Kürzel steht für „Generative Pre-trained Transformer“. Dieser Chat-Bot kann verschiedene Arten von Texten ausgeben und sogar Kurzgeschichten oder Gedichte schreiben – aber auch Fachfragen beantworten.

- Grundlage dafür sind neuronale Netze, die über eine immense Menge von Texten aus dem Internet kontinuierlich lernen. Dabei begreift ChatGPT aber überhaupt nicht die Bedeutung dessen, was es liest oder schreibt: Das Tool ist darauf trainiert, statistische Zusammenhänge von Wörtern zu analysieren. Das jeweils nächste Wort wird also immer aufs Neue berechnet. Manche Antworten sind denn auch purer Unfug: ChatGPT „halluziniert“ gerne mal, wie es beschönigend heißt.

- Um aktiv zu werden, braucht ChatGPT eine Art Gespräch, den Chat. Der menschliche Partner formuliert darin eine Arbeitsanweisung, den sogenannten Prompt. Darauf antwortet ChatGPT – und das recht schnell.

- Entwickelt wurde dieser Bot vom US-amerikanischen Software-Hersteller OpenAI. Ende November 2022 wurde er veröffentlicht, nach kaum einer Woche hatte sich schon eine Million Nutzerinnen und Nutzer angemeldet. Die im März 2023 vorgestellte Version GPT-4 kann mittlerweile auch Bilder analysieren und beschreiben.

Anja van Marwick-Ebner ist die aktiv-Expertin für die deutsche Textil- und Bekleidungsindustrie. Sie berichtet vor allem aus deren Betrieben sowie über Wirtschafts- und Verbraucherthemen. Nach der Ausbildung zur Steuerfachgehilfin studierte sie VWL und volontierte unter anderem bei der „Deutschen Handwerks Zeitung“. Den Weg von ihrem Wohnort Leverkusen zur aktiv-Redaktion in Köln reitet sie am liebsten auf ihrem Steckenpferd: einem E-Bike.

Alle Beiträge der Autorin